我們的服務

Ollama 本地部署教學,2025 最新支援模型,商業應用教學

你是否想在自己的電腦上運行強大的 AI 模型,又擔心資料外洩或網路不穩?別擔心!Ollama 是一個超簡單的開源工具,讓你輕鬆在本地部署大型語言模型(LLM),完全離線運行,私隱有保障!今天這篇 Ollama 教學 會帶你一步步上手,介紹 2025 年最新支援的模型,並分享實用技巧,讓你快速成為本地 AI 高手!💻

內容:

2025 年 Ollama 最新支援模型一覽

Ollama 安裝教學:5 分鐘上手

為什麼中小企需要 Ollama本地部署的AI?

Ollama官網下載: https://ollama.com/

什麼是Ollama本地部署?

Ollama 是一個專為本地部署設計的開源框架,讓你無需依賴雲端服務就能運行 AI 模型。它的優勢超明顯:

- 私隱第一:資料不離開你的電腦,無需上傳到雲端,特別適合注重資料安全的個人或企業。

- 離線運行:斷網也能用,適合處理隱私度高的資料。

- 簡單易用:幾行指令就能啟動,連新手都能快速上手。

- 支援多模型:從輕量到高效,涵蓋 2025 年最新的熱門模型。

就像你在遊戲中找到一個好用的查價工具,Ollama 就是本地 AI 的「神器」,幫你省時省力,還能省錢!

AI教學資源

直接看文章教學,不用真人上課,方便快捷

2025 年 Ollama 最新支援模型一覽

Ollama 不斷更新,2025 年支援的模型越來越強大,尤其以 DeepSeek 系列最受矚目。以下是幾個熱門選擇,適合不同需求和硬體:

- DeepSeek-R1:1.5b

- 參數量:1.5 億

- 大小:1.1GB

- 特色:輕量級模型,適合低配電腦(4GB RAM 即可)。支援數學、推理和簡單編碼任務

- 適用場景:學生、個人學習或輕量應用

- DeepSeek-R1:7b

- 參數量:70 億

- 大小:4.7GB

- 特色:性能媲美 OpenAI-o1,適合複雜推理、程式設計和文本生成

- 適用場景:開發者、研究人員或需要高性能的用戶

- DeepSeek-Coder

- 參數量:多種規格(1.5b 至 33b)

- 特色:專為程式設計優化,支援 Python、JavaScript 等多種語言,生成程式碼又快又準

- 適用場景:程式設計愛好者或專業開發者

- Mistral Small 3.1

- 參數量:未知(輕量級)

- 特色:快速推理,適合嵌入式應用或移動設備

- 適用場景:輕量部署或快速原型開發

5. Llama 4 Scout

- 大小:約 3GB(量化版本)

- 特色:輕量級多模態模型,支援文字與圖像處理,擅長快速推理。

- 商業應用:電商產品圖像分析(例如識別商品特徵)、簡易客服對話。

- 優勢:低資源需求,適合中小企業的普通伺服器(8GB RAM 即可)。

6. Llama 4 Maverick

- 大小:約 8GB

- 特色:進階多模態模型,支援複雜圖像理解與文字生成,推理能力媲美高階雲端 AI。

- 商業應用:行銷素材生成(例如從圖片生成廣告文案)、醫療影像初步分析。

- 優勢:適合配備 GPU 的大型企業,處理高解析度圖像效果佳。

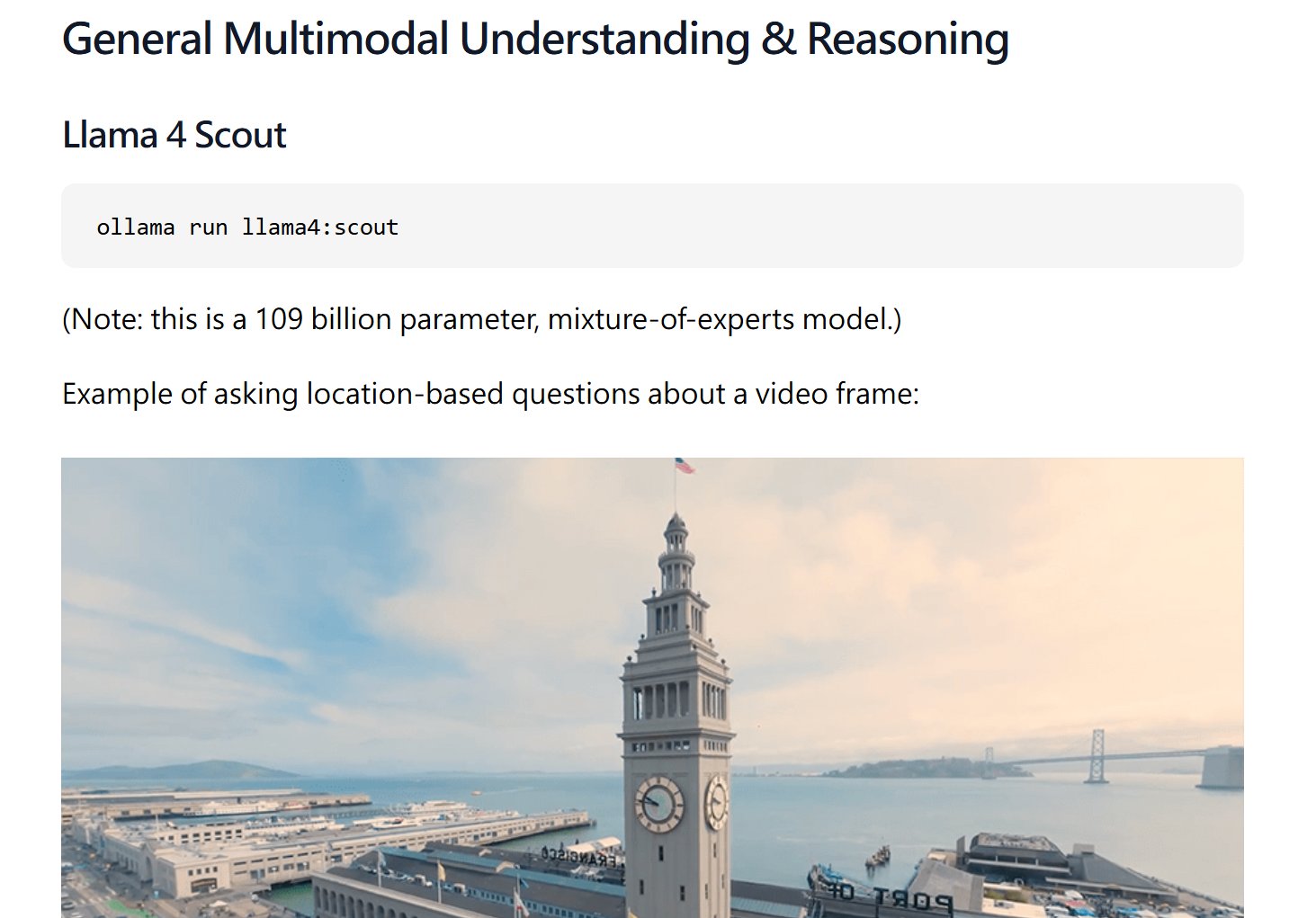

7. Qwen 2.5 VL

- 大小:5GB 至 10GB(依版本)

- 特色:高效視覺語言模型,支援多語言文字與圖像,特別擅長亞洲語言(如中文)。

- 商業應用:多語言客服(結合圖片與文字回應)、跨境電商產品描述生成。

- 優勢:對中文支援優異,適合香港及亞洲市場的企業。

8. Google gemma3

- Google Gemma 3 是 Google 在 2025 年 3 月 12 日發布的最新開源 AI 模型系列,基於 Gemini 2.0 的研究技術打造,專為高效能與輕量化設計。

- Gemma 3 提供多模態功能(文字 + 圖像),支援 140+ 種語言,上下文窗口高達 128k tokens,適合從手機到工作站的各種設備。

- 它的模型大小包括 1B、4B、12B 和 27B 參數,靈活適應不同硬體需求。Gemma 3 的出現讓企業和開發者能以低成本在本地部署強大 AI,特別適合注重資料隱私的商業應用。

這些模型就像遊戲裡的裝備,輕量款適合新手,重量級則給硬核玩家!根據你的硬體(CPU 或 GPU)和需求選擇即可

Source: https://ollama.com/blog/multimodal-models

Follow IG 看更多即時更新 : Instagram

Ollama 安裝教學:5 分鐘上手

安裝 Ollama 就像裝遊戲外掛一樣簡單!以下是針對 Windows、macOS 和 Linux 的通用步驟:

步驟 1:下載 Ollama

- 前往 ollama.com,點擊「Download」選擇你的作業系統版本。

- Windows/macOS:下載安裝包,雙擊運行即可。

- Linux:開啟終端,輸入以下指令:

bash

Copy

curl -fsSL https://ollama.com/install.sh | sh

這行指令會自動下載並設置環境。

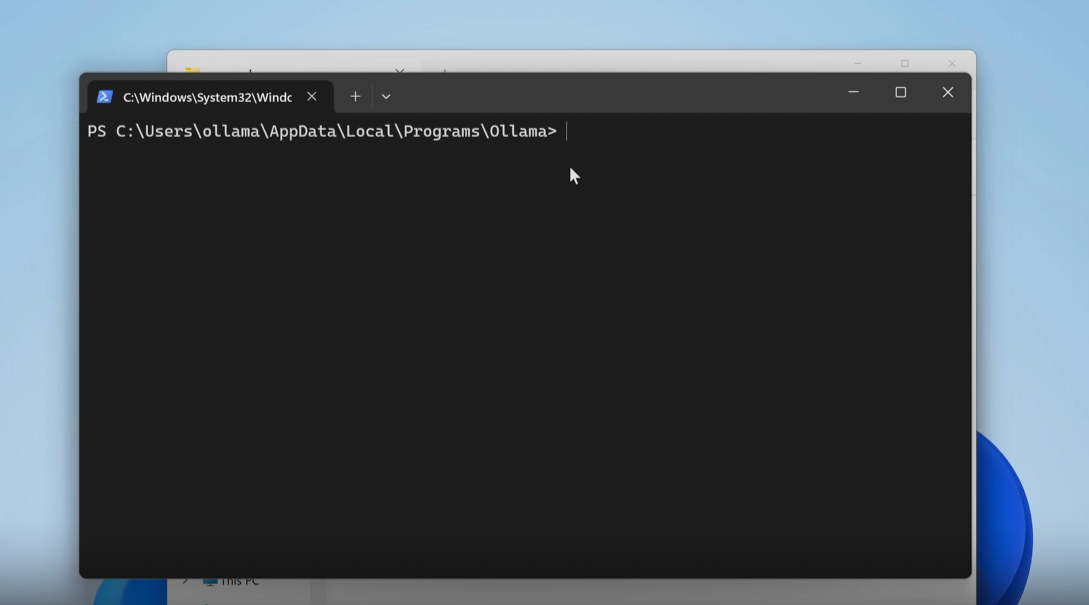

步驟 2:檢查安裝

安裝完成後,開啟終端(Windows 用 PowerShell,macOS/Linux 用 Terminal),輸入:

ollama --version

如果顯示版本號(例如 0.7.x),恭喜你,安裝成功!

步驟 3:拉取模型

選擇一個模型開始吧!以輕量級的 DeepSeek-R1:1.5b 為例:

ollama pull deepseek-r1:1.5b

這會下載模型到你的電腦(約 1.1GB)。想試更大模型?換成 deepseek-r1:7b 或其他型號。

步驟 4:運行模型

下載完畢後,輸入:

ollama run deepseek-r1:1.5b

這會啟動一個互動介面,你可以直接輸入問題,例如「幫我寫一段 Python 程式」或「解釋量子力學」。模型會即時回應,全部離線運行!

步驟 5:進階玩法(選做)

- API 整合:Ollama 提供本地 API(http://localhost:11434),可嵌入你的應用程式。

- Web 介面:搭配 Open WebUI,打造像 ChatGPT 的圖形介面,超方便!

就像學會查價後能快速賣道具,掌握這些步驟,你就能輕鬆玩轉本地 AI!

硬體需求與優化建議

Ollama 的靈活性讓它適配各種硬體,但不同模型對資源要求不同:

- 最低配置(DeepSeek-R1:1.5b):4GB RAM,普通 CPU,無需 GPU。

- 推薦配置(DeepSeek-R1:7b):16GB RAM,4 核心 CPU,有 GPU(NVIDIA/AMD)可加速。

- 高階配置(Llama 3.3 或更大模型):32GB RAM,高效 GPU(如 RTX 4090)。

優化小撇步:

- 量化模型:選擇量化版本(例如 4-bit 或 8-bit),大幅降低記憶體需求。

- 關閉背景程式:確保電腦資源專注於模型推理。

- 升級硬體:如果預算允許,添購 GPU 或增加 RAM 能顯著提升性能

為什麼中小企需要 Ollama本地部署的AI?

Ollama 是一個專為本地部署設計的開源框架,特別適合對資料隱私敏感的企業。它的核心優勢包括:

- 資料安全:所有資料留在本地,無需上傳雲端,符合 GDPR 等嚴格隱私法規。

- 成本控制:無需訂閱昂貴的雲端 AI 服務,長期省下大筆費用。

- 離線運行:無網路也能用,適合封閉環境(如金融、醫療)。

- 靈活定制:支援多種模型,輕鬆整合到企業應用。

商業應用案例:Ollama 如何幫企業?

以下是幾個真實場景,展示 Ollama 的商業價值:

程式碼生成(科技公司)

- 需求:加速內部工具開發,保障程式碼開發私隱度。

內容行銷

- 需求:快速生成產品描述和廣告文案。

- 解決方案:用 Gemma 2:9b 批量生成文案,人工微調後上架。

知識管理及整理客戶資料

- 需求:整理內部機密及客戶文件,支援多語言查詢,分析及整理客戶資料

- 解決方案:用 Llama 3.3:8b 構建內部知識庫,支援中英查詢。

更多應用及教學請訂閱我們的電子報,發你最新AI資訊